Künstliche Intelligenz (KI) in der Polizei: Welchen Nutzen hat die Technologie und welche Chancen und Risiken birgt sie? Um das zu diskutieren, ist es notwendig, die wichtigsten Begriffe rund um die Technologie zu verstehen und den historischen und aktuellen Kontext zu beleuchten.

Künstliche Intelligenz ist als Begriff nicht einheitlich definiert. Vor allem, da sie sich schon seit der Begriffsbildung Ende der 1950er Jahre als interdisziplinäre Forschungsrichtung entwickelt und sich in ihrer Deutung stets an die technischen Möglichkeiten angepasst hat. Für die praktische Anwendung hat sich folgende Definition als nützlich erwiesen: Künstliche Intelligenz beschreibt Informatik-Anwendungen, deren Ziel es ist, intelligentes Verhalten zu zeigen. Dazu sind in unterschiedlichen Anteilen bestimmte Kernfähigkeiten notwendig: Wahrnehmen, „Verstehen“ (Erkennen), Handeln und Lernen. Diese vier Kernfähigkeiten stellen die größtmögliche Vereinfachung eines Modells zur modernen KI dar. Wahrnehmen – Verstehen– Handeln erweitert das Grundprinzip aller EDV-Systeme: Eingabe – Verarbeitung – Ausgabe. Das wirklich Neue ist das Lernen. Heutige echte KI-Systeme haben gemeinsam, dass sie in der Verarbeitungsfähigkeit auch trainiert werden und damit lernen können. Angelernte Systeme haben mittlerweile eine gleichbleibende Performance mit einer Treffsicherheit von über 90 Prozent, z. B. bei der Bilderkennung und können zunehmend mit neuen Sachverhalten, die nicht Teil des Trainingsdatensatzes waren, umgehen. So erzielen sie bessere Ergebnisse als herkömmliche Verfahren, die nur auf starren, klar definierten und fest programmierten Regelwerken basieren.

Heute verfügen wir über eine schwache KI, die den Menschen beim Erreichen seiner Ziele unterstützen soll – also um smarte Mensch-Maschine-Interaktion und -Kollaboration. Die neueste Phase von KI-Systemen versucht daher, Lernverfahren mit Expertenwissen zu verbinden, um das Beste aus beiden Welten zu nutzen: Kontrolle und explizites Wissen mit der Kraft von Lernalgorithmen, die dann auch bei unsicherer Faktenlage ähnlich gut wie ein Mensch handeln können.

Die starke KI – also eine wahre künstliche Intelligenz, die eine Imitation des Menschen darstellt – ist bisher jedoch Science-Fiction.

Anwendungsbereiche von KI in der Polizei

In den USA oder Großbritannien ist der Einsatz von KI-Systemen in der Polizei Standard. Insbesondere die vorbeugende Datenanalyse ermöglicht im Rahmen des Predictive Policing die Erkennung möglicher Kriminalitätsschwerpunkte, auffälliger Aktivitäten oder die Erkennung von Mustern, sodass Einsatzkräfte gezielt disloziert werden können. In Deutschland findet der Einsatz von KI partiell im Bereich der Strafverfolgung und der Gefahrenabwehr statt. Die meisten Anwendungen und Projekte laufen im Rahmen des Bundeskriminalamtes (BKA), aber auch in den Landespolizeien. Beispiele sind u.a. bei der Auswertung von Kinderpornografie intelligenter Videoüberwachung von öffentlichen Räumen oder der Schuhspuranalyse zu finden. Das Bundesverfassungsgericht schränkte jedoch unlängst die automatisierte Datenauswertung (Data-Mining) zur Vorbeugung von Straftaten (Predictive Policing) ein. Hintergrund ist der mögliche Eingriff in die informationelle Selbstbestimmung, gemäß Artikel 2 Absatz 1 i.V.m. Artikel 1 Absatz 1 des Grundgesetzes. Solche Systeme dürften jedoch Verwendung finden, wenn eine Gefahr für Leib und Leben oder die Freiheit von Personen, bzw. der Schutz überragend wichtiger Rechtsgüter (z. B. ein Angriff auf den Fortbestand der Bundesrepublik Deutschland) bestehe – also einer hinreichend konkretisierten Gefahr.

Sicherheitsbehörden sehen sich steigenden Herausforderungen gegenüber, die eine Steigerung der Effektivität erfordern. Zum einen sinkt in den kommenden 15 Jahren die Anzahl erwerbstätiger Menschen. Das seit Jahrzehnten geltende Grundkonzept von Verwaltungs- und Sicherheitsbehörden, bei unzureichenden Ressourcen einfach personell zu wachsen, um auf neue Herausforderungen zu reagieren, geht dann folglich nicht mehr auf.

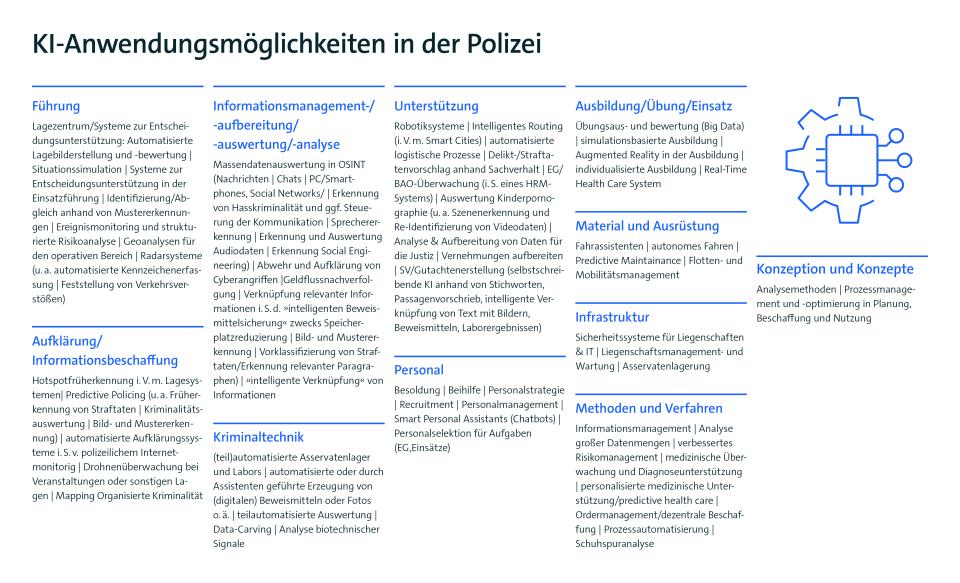

Zum anderen steigt das Datenaufkommen. Bereits heute stellt dies eine große Herausforderung für die Sicherheitsbehörden dar, da der Großteil davon unstrukturierte Daten sind. Allein in der Polizei Niedersachsen sind etwa 7,5 Petabyte Daten gespeichert. Diese Menge an Daten würde etwa 150 Millionen Aktenschränke füllen. Durch den weiteren Anstieg an Sensoren, mobilen Endgeräten (Smartphones, Tablets, etc.) sowie den Kapazitäten auf Speichermedien, wird diese Herausforderung weiter steigen. Hinzu kommt, dass sich Kriminalitätsphänomene immer weiter in den digitalen Raum verlagern und Sicherheitsbehörden stärker mit Daten in digitaler Form konfrontiert sind. Dies erfordert den Aufbau von weiteren Behördenkompetenzen, u. a. in der digitalen Forensik und Open Source Intelligence (OSINT). Es stellen sich technische Fragen nach Speicherkapazitäten, Rechenkapazitäten sowie geeigneter Software zur Auswertung dieser Daten. Diese Herausforderungen können nur im Dreiklang aus Politik (Rahmensetzung), Behörden (Durchführung) und Wirtschaft (digitale Kompetenzen und Ressourcen) konstruktiv und kooperativ gelöst werden. Der mögliche Einsatz von KI-Systemen gemäß der Abbildung 1 stellt eine Lösung der Herausforderung dar.

KI kann auf allen Ebenen der (Massen-)Datenverarbeitung eingesetzt werden, insbesondere bei spezialisierten und sich wiederholenden Aufgaben. Das bedeutet Daten zu erheben, zu speichern und zu analysieren. Dadurch können eine große Datenmenge strukturiert und handhabbar gemacht sowie Zusammenhänge aufgedeckt werden. KI kann als digitaler Assistent dienen, Muster erkennen und eine Vorauswahl für eine menschliche Entscheidung treffen. Dabei sollte der Mensch grundsätzlich das Recht auf eine finale Entscheidung behalten.

Herausforderungen für den Einsatz künstlicher Intelligenz in der Polizei

Der Einsatz von KI in den Sicherheitsbehörden bedarf eines gesetzlichen Rahmens, insbesondere wenn personenbezogene Daten verarbeitet werden. Das damit verbundene Recht auf informationelle Selbstbestimmung ist bei den meisten Anwendungen betroffen. Eingriffe in dieses Recht können auch dann vorliegen, wenn das Ergebnis einer Analyse einen „Nichttreffer“ erzeugt und die Daten umgehend gelöscht werden. Eine hohe Eingriffsintensität stellen in diesem Zusammenhang KI-Anwendungen dar, die verdachtslos und mit einer großen Streubreite agieren. Dabei werden diverse Personen involviert, die in keinem Zusammenhang zu einem Sachverhalt stehen, bzw. durch ihr Verhalten keinen Anlass einer Überprüfung gegeben haben. Ebenso ist eine vollständige „Durchleuchtung“ von Personen mit der Verfassung nicht vereinbar. Dies stellt Ermittlerinnen und Ermittler in der Praxis jedoch auch vor Herausforderungen. Gerade im extremistischen Umfeld kann es sinnvoll sein, alle Informationen zu einer Person für eine Lageanalyse zu erhalten, darunter auch deren emotionalen Zustand (z. B. bei Geiselnehmenden oder GewalttäterInnen).

Schließlich sind europäische Richtlinien zu beachten. Eine mittels KI automatisierte Entscheidungsfindung ist aufgrund Artikel 11 Abs. 1 und Abs. 2 der Richtlinie der EU 2016/680 möglich. Ein Profiling, das natürliche Personen auf Basis definierter Datenkategorien diskriminiert, ist hingegen nach Absatz 3 verboten.

Vor diesem Hintergrund ist es geboten, vor und während der Einführung von KI-Anwendungen, in den Sicherheitsbehörden die Datenschutzbeauftragten einzubinden, um rechtskonform zu agieren. Dies ist auch gemäß Paragraph 69 Abs. 1 Bundesdatenschutzgrundverordnung (BDSG) nötig, um die Rechtmäßigkeit der angestrebten Verarbeitung zu gewährleisten. Auch Paragraph 67 Absatz 1 der BDSG fordert bei der „Verwendung neuer Technologien“ eine Datenschutz-Folgenabschätzung. Aktuell stellt die Einhaltung der datenschutzrechtlichen Grundsätze Transparenz, Zweckbindung und Datenminimierung eine Herausforderung in der Praxis dar, die ggf. zu gesetzlichen Anpassungen führen muss. Der Gesetzgeber schätzt KI in Sicherheitsbehörden als besonders risikoreich ein und versieht sie daher mit Auflagen.

Die Europäische Union (EU) nimmt sich dem Thema im Rahmen des Artificial Intelligence Acts (AI Act) an, welcher voraussichtlich Ende 2023 verabschiedet wird. Dort werden KI-Anwendungen in Kategorien, mit entsprechenden Auflagen, eingestuft („unannehmbares Risiko“, „hohes Risiko“ und „solche mit bestimmten Transparenzanforderungen“).

Die Regularien des AI Act und die nach dem Entwurf der EU-Kommission vorgesehenen Haftungsregelungen für KI (AI Liability Directive – AILD) stellen Entwickler bestimmter KI-Anwendungen in Europa vor neue Herausforderungen. Strenge Regularien für KI, u. a. beim Aufbau von Qualitätsmanagementsystemen, bei technischen Dokumentationen, bei Datenanforderungen, etc., ergeben eine rechtliche Komplexität und damit erhöhte Kosten. Aufgrund der Komplexität und erschwerten Nachvollziehbarkeit von Entscheidungen von KI-Systemen, erhalten potenziell geschädigte Personen verhältnismäßig leichten Zugang zu Klagemöglichkeiten gegen Betreiber von KI-Systemen. Diesen droht nach dem aktuellen Entwurf der AILD gar die gerichtlich angeordnete Offenlegung von Informationen, wie etwa dem Quellcode. Dies greift in die Geschäftsgeheimnisse ein und bietet erhebliches Erpressungspotenzial. Auch könnten Trainingsdatensets gesperrt werden, wenn diese bestimmte persönliche Daten enthalten. Hinzu kommt, dass KI zudem in den Anwendungsbereich der überarbeiteten Produkthaftungsrichtlinie aufgenommen worden ist (Entwurf der Kommission aus September 2022). Da nach dem Entwurf keine Haftungshöchstsummen mehr für Schäden vorgesehen sind, stellen KI-Lösungen ein nicht kalkulierbares Risiko für Unternehmen dar. Insbesondere innovative Startups und mittelständische Unternehmen können diese Risiken und Regularien nicht übernehmen.

Auf Vorschlag der Kommission sind für Behörden zurzeit KI-Anwendungen verboten, die folgende Punkte umfassen:

- Manipulation von Personen

- Exploitation (Ausbeutung von Personen)

- ein Social Scoring (u. a. Einbeziehung von Persönlichkeitsmerkmalen oder sozialem Verhalten zur Analyse der Vertrauensfähigkeit von Personen

biometrische Identifizierung mittels Echtzeit-/Fernidentifizierungssystemen in öffentlich zugänglichen Räumen zur Strafverfolgung (Ausnahmen: Suche nach bestimmten Verdächtigen, Täterinnen und Tätern sowie Opfern und Abwendung unmittelbarer Gefahren.

Behörden müssen daher genau definieren, in welchen Szenarien KI-Anwendungen einen konkreten Mehrwert bieten.

Um die Sicherheitsbehörden von technologischen Entwicklungen durch langwierige juristische Debatten nicht abzuschneiden, sollten KI-Anwendungen für die Polizei in Fallgruppen kategorisiert werden, um bezogen auf einzelne Use Cases ethisch, rechtlich, sozial, aber auch technisch betrachtet zu werden (auf eine ethische und soziale Debatte wird an dieser Stelle nicht gesondert eingegangen).

KI-Anwendungen in der Polizei müssen Aspekten des Datenschutzes und der Datensicherheit entsprechen. Ihre Ergebnisse müssen gerichtsfest sein, auf Basis gesetzlicher Grundlagen. Dies verlangt eine Transparenz der Methodik, eine aktuelle Datenlage sowie eine reglementierte Verfügbarkeit der Daten für bestimmte Personen. Dabei darf auch der Faktor Mensch nicht außer Acht gelassen werden. Für Bedienstete müssen daher Anwendungen leicht bedienbar sein, ohne große technische Vorkenntnisse.

Technische Anforderungen an KI

Daten in guter Qualität sind die Grundlage für erfolgreiche KI-Anwendungen. Unzureichende Datensätze führen zu einem verzerrten Lagebild. Der Trainingsphase des Systems kommt somit eine entscheidende Bedeutung zu – insbesondere, um menschliche Einflüsse wie Diskriminierung oder die Korrektheit von Informationen zu gewährleisten. Dies erfordert ein intelligentes Datenmanagement, was die Daten so aufeinander abstimmt und zur Verfügung stellt, dass die jeweilige KI-Anwendung optimal darauf zugreifen kann. Daher müssen Datenmanagement und KI-Anwendung gut koordiniert sein, unter Aspekten der Schnittstellenfähigkeit und Informationssicherheit beim Datenaustausch. Die Komplexität von Prozessen und der sie abbildenden Verfahren nehmen dabei stetig zu. Daher steigt auch das Risiko fehlender Transparenz und Nachvollziehbarkeit bei den angewendeten Methoden. Dies umfasst u. a. die Menge der gespeicherten und übermittelten Daten. Auch die Wichtigkeit von Informationen zur und während der Verarbeitung nimmt durch immer bessere Sensoren weiter zu. Diese Aspekte und die Überprüfbarkeit der Validität, der daraus erzeugten Ergebnisse, sind rechtlich essenziell. Vor Gericht kann es sein, dass auf KI basierende Entscheidungen im Einzelfall vollständig nachvollziehbar sein müssen. Dabei sind die Personalressourcen für Verfahrensbearbeitungen begrenzt und werden zunehmend geringer. Daraus gewonnene Ergebnisse müssen gleichzeitig immer schneller bewertet werden und bedürfen analytischer und kognitiver Unterstützung beim Prozess der Entscheidungsfindung. Neben den KI-Anwendungen sollten somit auch Techniken betrachtet werden, die deren Ergebnisse für Anwendende nachvollziehbar machen.

Die Erlangung technischer Lösungen

Für Sicherheitsbehörden stellt sich somit die Frage, wie sie Zugang zu solchen Technologien erhalten. Dabei bekommen sie oft erst Gelder, nachdem ein Schadensereignis eingetreten ist, welchem nun – meist politisch motiviert – abgeholfen werden muss. Beim anschließenden Aufbau von technischen Kompetenzen stellen sich dann weitere Herausforderungen ein. Vor allem der Zugang zu validen und verlässlichen Test- und Trainingsdaten, die zudem unter Berücksichtigung von ethischen, datenschutz- und allgemeinen rechtlichen und technischen Standards bestehen, ist kritisch. Auch die Einbeziehung externer Akteure, gerade bei Vertrauenssachen, wird hinterfragt. Dabei ist der Aufbau eines eigenen Ökosystems aus eigenen Personalressourcen, Wirtschaft und Wissenschaft dringend geboten.

Die Polizei sollte sich auf ihre Kernaufgaben und Kernfähigkeiten fokussieren. Die Entwicklung von Software gehört nicht dazu. Argumente, dass wirtschaftliche Lösungen zu teuer seien oder man selbst am besten wisse, was man benötigt, stehen immer wieder im Raum. Dabei ist jedoch zu berücksichtigen, dass eigene ExpertInnen bei der Programmierung zu beschäftigen, ggf. teurer sein kann, als eine Marktlösung, die in einem gemeinsamen iterativen Prozess abgestimmt wurde und an die Bedürfnisse der Polizei angepasst ist. Software ist heutzutage so komplex, dass sie nicht mehr vollständig getestet werden kann. Sie wird daher nicht einmalig entwickelt und steht dann unmittelbar zur Verfügung. Vielmehr bedarf es einer ständigen Anpassung, was dann Daueraufgabe der Programmierenden innerhalb der Behörde ist. Deren Unterhalt kann über mehrere Jahre also teurer als eine Auslagerung von Services in die Wirtschaft sein. Auch sollten ggf. Lösungen, die nur zu 80 Prozent den Anforderungen entsprechen, in Betracht gezogen werden, gerade weil die Software stets weiteren Anpassungen unterliegt. Dies müsste bei Ausschreibungen Berücksichtigung finden. Schließlich verfügen viele Marktteilnehmer auch über sicherheitsüberprüfte Zertifizierungen, die sie zum Umgang mit vertraulichen Inhalten befähigen. Im Verteidigungssektor ist diese Zusammenarbeit Standard und daher auch für die Sicherheitsbehörden des Inneren nutzbar. So kann die Technologie auch für die Polizei vollumfänglich adaptiert werden.

Durch Leuchtturmprojekte können zudem Erfahrungswerte für Folgeprojekte gesammelt werden. Dabei muss eine klare Ansprechstelle für KI-Themen organisatorisch verortet werden, um das KI-Thema fokussiert voranzutreiben.

Crisis Prevention 2/2023

Oberstleutnant d.R. Stephan Ursuleac

Referent Verteidigung & ÖffentlicheSicherheit | Bitkom e. V.

Email: s.ursuleac@bitkom.org