Sicherheitsanalysen von Systemen und Netzen: Möglichkeiten, Herausforderungen und Grenzen

Fregattenkapitän Dr. Robert Koch, Dezernatsleiter Penetrationstests im Zentrum für Cyber-Sicherheit der Bundeswehr

Die heutige Informations- und Kommunikationstechnologie (IKT) vernetzt geschäftliche, öffentliche und private Bereiche umfassender denn je und ist Grundlage nicht nur für Handel und Entwicklung, sondern für den gesamten, modernen Alltag – ob sichtbar in Form von Rechnern und Smartphones oder im Hintergrund verborgen, beispielsweise in Steuerungssystemen und der kritischen Infrastruktur.

Durch die Sensitivität vieler Anwendungsbereiche bzw. Daten ist deren Vertraulichkeit und Integrität von essentieller Bedeutung, während die Geschwindigkeit globalisierter Prozesse eine jederzeitige Verfügbarkeit erfordert – die drei grundlegenden Schutzziele der Informationssicherheit, welche mitunter auch als CIA-Triade bezeichnet werden, von den englischen Begriffen Confidentiality, Integrity und Availability.

Firmware und Hardware können das Ziel versierter Angreifer und schwer detektierbarer Manipulationen werden.

Ein Blick in die Medienlandschaft zeigt jedoch, dass die Schutzziele immer wieder verletzt werden, Nachrichten über Hacks oder Datenskandale erscheinen mit Regelmäßigkeit, und Untersuchungen schätzen die wirtschaftlichen Verluste alleine für Deutschland, welches von Cyberkriminalität besonders stark betroffen ist, auf einen hohen, zweistelligen Milliardenbetrag pro Jahr. Hier stellt sich entsprechend die Frage nach den Ursachen; oftmals sind schlechte Cyberhygiene, verlorene und unverschlüsselte Datenträger, fehlerhaft konfigurierte Datenbanken oder auch nicht deaktivierte Accounts ehemaliger Mitarbeiter einfache und gern genommene Angriffsvektoren.

Auch wenn zunehmend Systeme mit höherem Sicherheitsniveau marktverfügbar sind, beispielsweise basierend auf Mikrokernen wie der L4-Familie oder zertifiziert auf Basis der verschiedenen Evaluation Assurance Levels (EAL) der Common Criteria (CC, ISO 15408), welche somit mitunter umfassende Anforderungen an die erforderlichen IT-Sicherheitsüberprüfungen der jeweiligen EAL-Stufen erfüllen, scheint sich die Sicherheitssituation nicht wesentlich zu verbessern. Die Frage ist daher, ob der Schein trügt oder welche Herausforderungen bei der Verbesserung der Sicherheit im Cyberraum bestehen.

Herausforderungen der Cybersicherheit

Die Überprüfung und Gewährleistung bzw. Verbesserung der Sicherheit von Systemen und Netzen ist auch nach Jahren intensiver Bemühungen sowohl der Forschung als auch der IT-Sicherheitsindustrie aufgrund mehrerer Faktoren ein immer noch offenes Feld.

Eine zentrale Rolle spielt dabei die Komplexität der heutigen IKT sowie der immer weitergehenden Vernetzung, wie auch die zunehmende Verschmelzung von den einst separierten Domänen Informationstechnologie (IT) und Betriebstechnologie (OT). Dabei ist insbesondere zu beachten, dass die Systemkomplexität auch weiterhin mit erheblicher Geschwindigkeit zunimmt; auf der anderen Seite sind moderne Prozessoren so leistungsfähig und günstig, dass auch in Systemen, in denen eigentlich nur eine sehr geringe Funktionalität benötigt wird, Universalrechner des Massenmarktes verbaut werden – so dass diese Systeme sehr viel mehr können, als sie eigentlich müssen oder gar sollen. Dies hat eine weitere, erhebliche Steigerung der Gesamtkomplexität zur Folge und eröffnet Angriffsvektoren, die aufgrund der eigentlichen Funktionalität eines Systems nicht ohne weiteres erkennbar sind – Thomas Dullien1 bezeichnete diesen Effekt als „Anomalie der einfachen Komplexität“2.

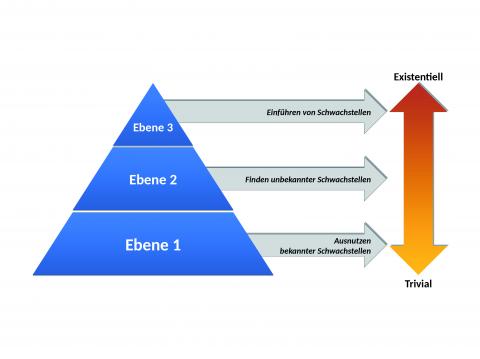

Gosler und von Thaer): Auf der untersten Ebene findet sich die Ausnutzung bereits bekannter Schwachstellen wie bspw. in den CVE hinterlegt; die zweite Ebene nutzt öffentlich noch nicht bekannte Schwachstellen aus, während Angreifer der dritten Ebene neue Schwachstellen in Systeme und Verfahren einschleusen, bspw. in Form von Hardwaretrojanern.

Daneben existiert weiterhin eine diversifizierte Landschaft aus Alt- und proprietären Systemen, welche stellenweise bereits seit Jahrzehnten nicht mehr aktualisiert bzw. gepflegt werden und deren Austausch in gewachsenen Strukturen oftmals mit erheblichen Herausforderungen verbunden ist; hiervon sind nicht nur beispielsweise veraltete Softwareapplikationen in großen Behörden betroffen, insbesondere auch Kontroll- und Steuerungssysteme in der Industrie oder kritischen Infrastruktur, welche oftmals im 24/7-Betrieb laufen und über lange Zeit amortisiert werden, finden sich zuhauf. Aber auch neuere Systeme nutzen oftmals keinen der verfügbaren Ansätze zugunsten einer höheren Sicherheit, sondern aufgrund der schnellen Produktzyklen und dem hohen Marktdruck ist es in vielen Bereichen für die Unternehmen immer noch ökonomischer, ein weniger ausgereiftes Produkt möglichst schnell auf den Markt zu bringen und später nachzubessern, als das Nachsehen vor der schnelleren Konkurrenz zu haben.

Bei der Betrachtung der Sicherheit sind aber auch weiterhin die Ursprünge des Internets nicht zu vernachlässigen, da das Design des ARPANET bis heute erhebliche Auswirkungen auf die Cybersicherheit hat. Geschaffen in einer vertrauensvollen Umgebung gegenseitiger Bekanntheit mit sehr wenigen, hoch ausgebildeten Akteuren (die ersten vier im Jahre 1969 vernetzten Standorte waren die University of California, Los Angeles (UCLA), das Stanford Research Institute (SRI), die University of California, Santa Barbara (UCSB) sowie die University of Utah) und den damaligen, sehr geringen Systemressourcen, war weder die Notwendigkeit noch die technische Möglichkeit vorhanden, umfassende Sicherheitsmaßnahmen zu implementieren; auch konnte der im weiteren Verlauf überwältigende Erfolg und die Geschwindigkeit und Tiefe der Ausbreitung und Erweiterung des Netzes von keinem der Beteiligten vorhergesehen werden.

Aufgrund der rapiden Evolution und der stetigen Erweiterung und Weiterentwicklung wurden die dann alsbald notwendigen Sicherheitsverfahren jedoch nicht inhärent integriert, sondern im Rahmen der vorhandenen Protokolle und Technologien typischerweise aufgesetzt und Vorhandenes Stück für Stück mit Sicherheitsfunktionalität erweitert – in Kontrast zum heutzutage oftmals geforderten Ansatz des „Security by Design“.

Auch mit zunehmender Verfügbarkeit neuer Systeme und Technologien mit höherer oder gar, zumindest nach Kenntnisstand der Wissenschaft, physikalisch garantierter Sicherheit, wird von Institutionen verschiedener Staaten immer wieder die Forderung nach Zugriffsmöglichkeiten auf Systeme und Verschlüsselungen laut, wie beispielsweise bei der Ende 2018 von der europäischen Standardisierungsorganisation ETSI spezifizierten Variante Enterprise TLS (ETLS) ersichtlich, welche den neuen Verschlüsselungsstandard TLS 1.3 schwächt.

Neben diesen erkennbaren Gefährdungen gilt es zudem, die Gefährdung durch bewusst eingebrachte Manipulationen zu berücksichtigen – insbesondere in sicherheitskritischen Umgebungen.

Dies können beispielsweise wie in den Snowden-Dokumenten belegt, speziell konstruierte Algorithmen sein, Hardwareimplantate, welche im Rahmen der Versorgungskette in Systeme eingebaut werden oder Hintertüren in Hard- und Firmware. In der Summe ergibt sich somit ein dreistufiges Bedrohungsmodell, wie in Abbildung 1 visualisiert.

Abgrenzung der Analyseverfahren

Um diesen Gefährdungen entgegenzuwirken, ist mittel- bis langfristig insbesondere eine geeignete, sicherheitsorientierte Auswahl und Kontrolle von Standards und Produkten erforderlich. Eine hinreichend sichere Systemumgebung ist aufgrund der zuvor diskutierten Komplexität der derzeitigen Strukturen aber selbst dann noch nicht absehbar. Entsprechend gilt es, durch geeignete Analyseverfahren die Bedrohungsebenen mit Hinblick auf den Schutzbedarf der jeweiligen Systeme zu untersuchen und erkannte Angriffsvektoren zu mitigieren, also deren Eintrittswahrscheinlichkeit oder Schweregrad zu reduzieren.

Abhängig von der Gefährdung und des Schutzbedarfs des zu untersuchenden Systems lassen sich verschiedene Analyseverfahren, welche sich gegenseitig ergänzend eingesetzt werden können, unterscheiden. Ziel einer Schwachstellenanalyse ist das Finden möglichst aller bekannten technischen Schwachstellen im zu prüfenden System, welche beispielsweise in Verzeichnissen wie den Common Vulnerabilities and Exposures (CVE) der MITRE Corporation geführt werden, wobei insbesondere Tools zur automatisierten Suche nach Schwachstellen zum Einsatz kommen.

Deren Ergebnisse sind jedoch regelmäßig noch manuell zu überprüfen und bewerten, um qualitativ hochwertige Ergebnisse zu erhalten. Auf dieser Basis gilt es dann, das System gegen alle darin vorhandenen bekannten Schwachstellen abzusichern und somit die Ebene 1 des Bedrohungsmodells zu adressieren. Penetrationstest gehen darüber hinaus noch weiter und versuchen, so viele Schwachstellen wie möglich in einem Netz oder System zu identifizieren. Diese können somit auch nicht-technischer Art sein, insbesondere ist das Ziel aber auch das Auffinden neuer, bisher nicht bekannter Schwachstellen und somit die Reduzierung von Angriffsvektoren auch auf Ebene 2 des Bedrohungsmodells. Hierzu können Werkzeuge wie beispielsweise Codeanalyse und Fuzzing3 eingesetzt werden.

Inhärent zu jedem Penetrationstest gehört weiterhin die exemplarische Ausnutzung von gefundenen Schwachstellen bzw. Angriffsvektoren. Dies erfolgt nach Rücksprache mit den jeweiligen Systemverantwortlichen und ermöglicht eine realistische Risikobewertung: Das Auffinden von Schwachstellen sagt oftmals noch nichts über die Möglichkeiten und Aufwände aus, welche einen Angreifer durch den jeweiligen Vektor offeriert werden. So kann die erfolgreiche Exploitation von verschiedenen Seitenfaktoren abhängen und das verbundene Risiko entsprechend beeinflussen – positiv wie negativ.

Neben diesen Verfahren können noch weitere Techniken zum Einsatz kommen, beispielsweise in Form von Red Teaming, bei dem ein Zielsystem in einem Blackbox-Ansatz über eine von außen erreichbare Schnittstelle angegriffen wird und somit die Sicht des Angreifers nachgestellt wird. Im Gegensatz zum Penetrationstest reicht hier das Auffinden bereits einer geeigneten Schwachstelle aus, um in das Zielsystem einzudringen; anschließend erfolgt typischerweise noch eine Lateralbewegung zur Analyse der Umgebung und dem Auffinden der wertvollen Systeme.

Da bei dieser Technik im Gegensatz zu den vorher genannten die Beschäftigten eines Unternehmens regelmäßig nicht informiert sind, sondern lediglich die Leitungsebene Kenntnis über die Durchführung hat, können insbesondere organisatorische Abläufe und Prozesse überprüft werden – was passiert, wenn ein Alarm ausgelöst wird, sind Verfahrensabläufe festgelegt, werden diese eingehalten und funktionieren sie? Während Schwachstellenanalysen und Penetrationstests also die Hürde für den Angreifer durch das Schließen von Angriffsvektoren erhöhen, prüft Red Teaming die erreichte Höhe der Sicherheitsmaßnahmen und die Funktionsfähigkeit der Abläufe – durch Zusammenwirken und entsprechenden Wiederholungen lässt sich die Sicherheit eines Systems oder Netzes somit schrittweise erhöhen, wobei die zunehmend höhere Angriffsschwelle mit dem entsprechenden Aufwand auf der Analyseseite verbunden ist.

Ausblick

Beachtet werden muss, dass gegen Angriffe auf Ebene 3 regelmäßig noch keine umfassenden Schutzmaßnahmen und Analyseverfahren zur Verfügung stehen. Zwar sind zunehmend Technologien zur Erkennung und Vermeidung von beispielsweise Hardwaremanipulationen in Entwicklung und stellenweise auch schon im Einsatz, die vielfältigen Möglichkeiten eines entsprechend kapablen Angreifers auf Ebene 3 lassen jedoch zahlreiche, kaum detektierbare Vektoren offen.

Hier gilt es, entsprechende Szenare zu analysieren und zu bewerten und darauf basierend, Notfallpläne zu erstellen und regelmäßig im Realbetrieb zu beüben, sowie durch die eingangs geforderte, geeignete Produktauswahl die Angriffsfläche kontinuierlich zu reduzieren. Aufgrund der stellenweise sehr aufwändigen Sicherheitsanalysen und den begrenzten Kapazitäten in diesem Bereich gilt es weiterhin, Möglichkeiten von Kooperationen und gegenseitiger Unterstützung bei den entsprechenden Akteuren zu prüfen, weiter auszubauen und voranzutreiben.

1 Sicherheitsforscher, der u. a. zwei Jahre bei Google Project Zero gearbeitet hat.

2 Gem. Thomas Dullien „Anomaly of cheap complexity“

3 Testverfahren, bei dem zufällige Werte über die Eingabeschnittstelle eines Programms eingespielt werden und das Programmverhalten auf Abstürze und Anomalien hin untersucht wird.

Crisis Prevention 1/2019

Fregattenkapitän Priv.-Doz. Dr. rer. nat.

Dr. habil. Dipl.-Inf. (univ.) Robert Koch

Dezernatsleiter Penetrationstests im Zentrum für Cyber-Sicherheit der Bundeswehr

Forschungs- und Lehraufträge an der Universität der Bundeswehr München, der Rheinischen

Friedrich-Wilhelms-Universität Bonn und

am Fraunhofer-Institut für Kommunikation, Informationsverarbeitung und Ergonomie